En lançant en octobre 2022 la campagne COllectivisons INternet / COnvivialisons INternet (coin coin pour les intimes), nous annoncions notre ambition de poursuivre le mouvement émancipateur lancé par Dégooglisons Internet et approfondi par Contributopia, sans limiter nos actions aux « petits gestes individuels de dégooglisation ». Notre objectif : fournir des outils numériques aux associations et collectifs qui œuvrent pour le bien commun et le bien des Communs.

Un peu plus de deux ans après le lancement de cette feuille de route, il est temps pour nous de vous présenter le bilan des 4 projets la constituant.

Emancip’Asso, favoriser l’émancipation numérique du monde associatif

Première étape : accompagner la montée en compétences des fournisseurs de services numériques éthiques

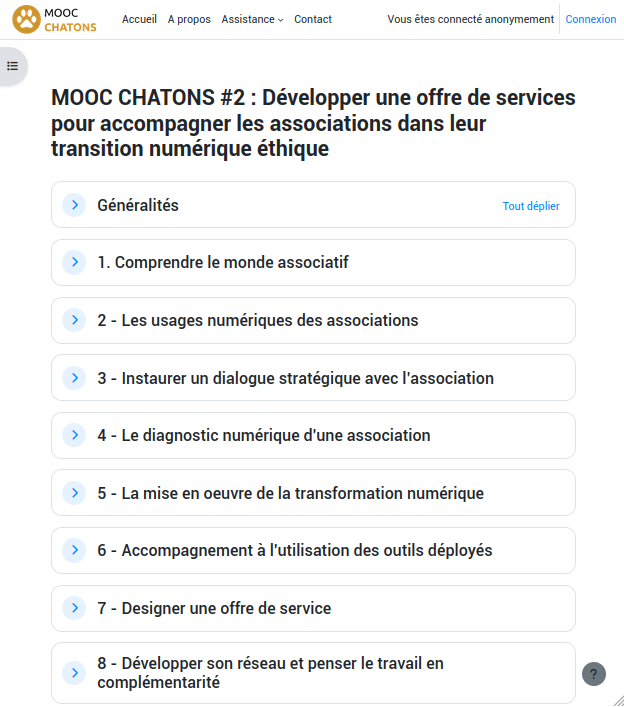

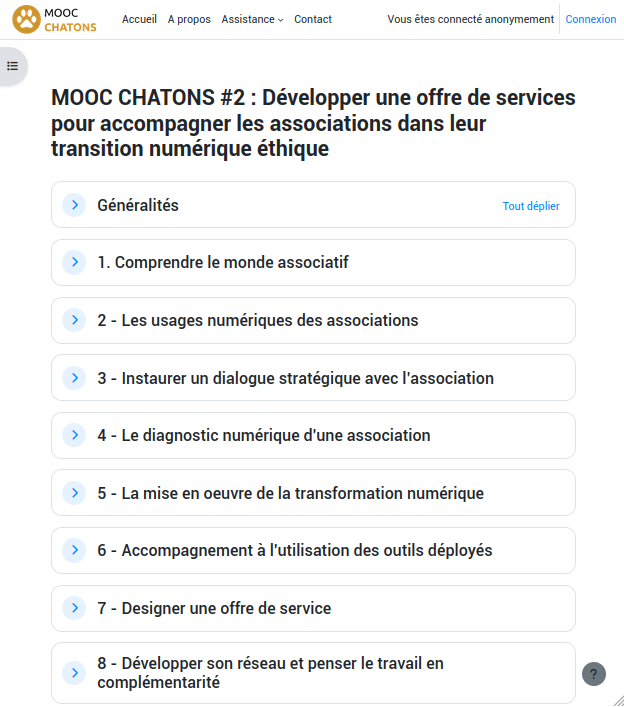

Ayant constaté que les fournisseurs de services numériques éthiques étaient peu nombreux à proposer des solutions prenant réellement en compte les besoins des associations, notamment l’accompagnement nécessaire pour mener à bien une démarche de transition vers des outils numériques libres, nous avons souhaité accompagner la montée en compétences de ces acteurices à travers deux dispositifs : une formation et un cours en ligne (MOOC).

Nous avons publié le bilan complet de ces dispositifs sur le Framablog fin 2023. Rappelons tout de même que 20 personnes se sont retrouvées à Paris en janvier 2023 pour participer à la formation « Développer une offre de services pour accompagner les associations dans leur transition numérique éthique » et que courant 2023, cette formation a été transposée en cours en ligne sur la plateforme https://mooc.chatons.org/.

C’est bien évidemment à son lancement il y a un an que la fréquentation du MOOC a été la plus importante : plus de 2000 consultations des leçons en décembre 2023 (dont 1253 provenant d’apprenant⋅es identifié⋅es) et 1150 en janvier 2024. À compter de février, on note une consultation bien plus faible, mais régulière des leçons à hauteur de 120 consultées en moyenne chaque mois. Sachant qu’il est possible de suivre le MOOC de manière anonyme, il n’est pas aisé de déterminer le nombre réel d’apprenant⋅es, mais on comptabilise 91 comptes créés qui ont suivi tout ou partie du MOOC.

Seconde étape : un site web pour que les associations trouvent qui peut les accompagner dans leur émancipation numérique

Si le site emancipasso.org a été réalisé au cours de l’année 2023, c’est en mars 2024 que nous avons communiqué spécifiquement à son sujet auprès des associations. La campagne de communication « Associations : les géants du numérique, c’est pas automatique ! » s’est articulée autour d’articles de blog (l’un présentant le projet, les autres documentant la démarche de plusieurs associations en cours de transition), de publications sur les réseaux sociaux (#EmancipAsso) pour visibiliser les prestataires du répertoire et célébrer les associations qui ont mis en cohérence leurs outils et leurs valeurs, d’un webinaire de présentation et d’une campagne d’emailing auprès des organisations de l’ESS.

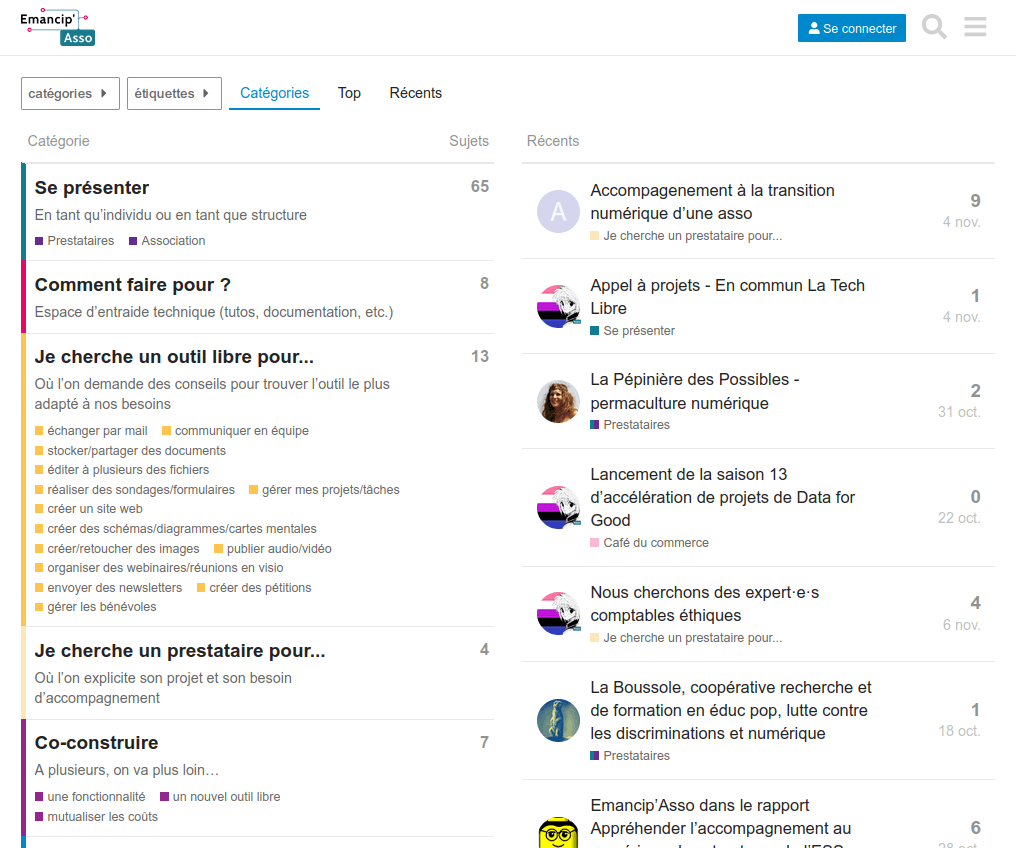

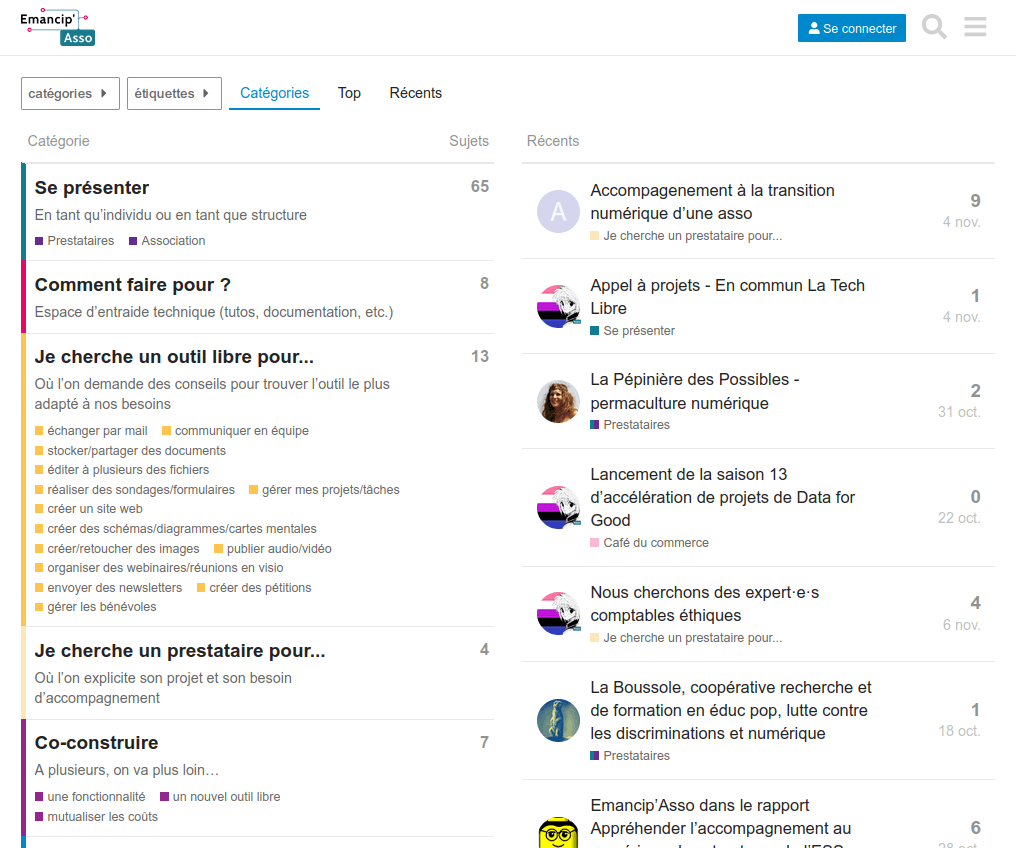

S’il est difficile d’évaluer si cette campagne a permis aux associations de prendre conscience de l’incohérence qu’il y a à vouloir changer le monde en utilisant les outils du capitalisme, on peut se féliciter que la communauté Emancip’Asso, espace d’entraide pour échanger bonnes pratiques, conseils et astuces, ait progressivement été rejointe par des associations et des acteurices de l’écosystème du numérique émancipateur. On comptabilise à ce jour 145 comptes, dont quasiment la moitié (48,3 %) y ont contribué. Au total, la communauté a accueilli 105 échanges, lesquels représentent au total 360 messages. Ces échanges sont principalement initiés par des membres d’associations pour exprimer des besoins techniques ou stratégiques. La communauté (prestataires et/ou autres associations) y répond rapidement (délai de moins de 3 jours en général) et on estime que le niveau de satisfaction est élevé. De plus, l’outil est un bon moyen pour les prestataires recensés dans le répertoire de valoriser leur savoir-faire.

On peut aussi se réjouir de voir de plus en plus de prestataires soumettre leur candidature pour intégrer le répertoire. En l’espace d’un an, leur nombre a doublé : ils étaient 25 en décembre 2023, 33 au lancement de la campagne de communication en mars et 52 désormais.

Enfin, afin de faire connaître Emancip’Asso au plus grand nombre, nous l’avons présenté à plusieurs reprises en 2024 :

- le 31 janvier au Forum national de l’ESS (Niort)

- le 25 avril lors d’un webinaire pour le réseau Numéris’Asso

- le 26 mai aux Journées du Logiciel Libre (Lyon)

- le 10 juin aux Rencontres Professionnelles du logiciel libre (Lyon)

- le 26 septembre lors d’un webinaire pour la communauté de la Fondation Crédit Coopératif

- le 13 novembre au Forum National des Associations et fondations (Paris)

- le 23 novembre au Campus du Libre (Lyon)

- le 10 décembre lors d’un mardi de l’ESS (Lyon) sur Les Communs numériques, leviers de la transformation sociale

Perspectives

Emancip’Asso n’en est qu’à ses débuts et a vocation à durer dans le temps, pour convaincre toujours plus d’associations de mettre en cohérence leurs outils numériques avec leurs valeurs.

Nous allons continuer à faire connaître le site emancipasso.org en :

- communiquant régulièrement sur les prestataires recensés dans le répertoire ;

- présentant les ressources qui y sont répertoriées ;

- animant la communauté Emancip’Asso ;

- développant les partenariats avec les fédérations d’associations ;

- développant notre présence lors des événements nationaux du secteur associatif ;

- animant webinaires de présentation, ateliers ou conférences.

Et nous comptons sur le bouche-à-oreille pour que ce site devienne une ressource incontournable pour toutes les associations : n’hésitez pas à présenter cet outil à vos associations préférées !

Si vous le souhaitez, vous pouvez nous donner les moyens de continuer à faire découvrir Emancip’Asso auprès des nombreuses associations qui utilisent encore les outils des géants du web.

Soutenir Emancip’Asso (et Framasoft)

Peer.Tube, mettre en valeur le PeerTube pour lequel nous œuvrons

PeerTube pouvant être utilisé par toutes et n’importe qui, on peut parfois trouver tout et n’importe quoi dans cet univers de vidéos, dont des contenus qui ne nous correspondent pas du tout. Ce n’est pas notre rôle de les interdire, mais cela peut être notre rôle de promouvoir des vidéos sur PeerTube qui nous rendent fièr·es de tout ce travail que nous fournissons depuis plus de 7 ans sur ce logiciel.

Notre idée était donc de créer sur le site peer.tube une vitrine de vidéos PeerTube qui nous enthousiasment. En réalisant ce travail de curation, via la sélection de contenus de qualité, nous aurions ainsi pour répondre à celles et ceux qui nous demandent comment trouver des vidéos intéressantes sur PeerTube : essaye sur peer.tube !

Nous avions prévu 4 axes de développement sur ce projet :

- se fédérer avec des instances et chaînes au contenu original,

- partager nos choix de fédération pour que d’autres instances puissent les suivre,

- permettre à des créatrices de contenus qui ne trouvent pas leur place sur d’autres instances de candidater pour avoir un compte sur peer.tube,

- tenter de faire communauté avec les administratrices et administrateurs d’autres instances qui ont établi leur ligne éditoriale.

Si, en 2022, nous avions déjà commencé ce travail en proposant sur peer.tube une sélection de chaînes « qui valent le détour » et de quelques playlists en anglais et en français, nous n’avons au final pas trouvé l’énergie et la disponibilité d’avancer davantage dans ce projet.

Pour autant, le besoin est, selon nous, toujours d’actualité. Nous avions d’ailleurs pensé que l’application PeerTube que nous venons de publier pourrait en partie y répondre. Mais c’était avant qu’on découvre que les magasins d’applications d’Apple (AppStore) et Google (PlayStore) n’étaient manifestement pas prêts à héberger un client pour (non pas une plateforme mais) un réseau de plateformes autonomes de partage de vidéos. Ainsi, pour pouvoir publier l’application PeerTube, nous avons dû présenter l’application mobile avec une « liste autorisée » de plateformes PeerTube répondant à leurs normes. Normes qui font que certains comptes et certaines chaînes que nous trouvons pertinents (et qui sont déjà dans notre sélection sur https://peer.tube/) en sont exclus.

Si le projet Peer.Tube n’a pas vu le jour sous la forme qu’on avait imaginée en 2022, on espère cependant qu’on pourra envisager sa transformation (ou sa relance) prochainement. En 2025, on aimerait continuer à mettre un peu d’énergie et de moyens pour davantage valoriser les contenus de qualité postés sur le réseau PeerTube. Cela pourrait être en prolongeant l’expérience de la newsletter de l’écosystème PeerTube envoyée en avril dernier… ou bien d’une toute autre façon…

Si vous pensez que c’est une bonne idée, n’hésitez pas à nous le faire savoir : quelques encouragements en commentaire et/ou votre soutien financier nous serons très précieux.

Soutenir la promotion de PeerTube (et Framasoft)

Framaspace, cloud convivial pour collectifs solidaires

Deux ans après l’annonce de Framaspace, un environnement de travail en ligne collaboratif pour outiller les associations et collectifs qui veulent changer le monde, 1627 organisations ont rejoint ce service gratuit basé sur le logiciel libre Nextcloud. C’est 125 de plus depuis la publication de l’article de blog du 26 novembre, ce qui nous conforte dans l’idée que ce service répond bien à un besoin.

Un environnement de travail collaboratif tout-en-un…

Entre la version beta lancée le 15 novembre 2022 et aujourd’hui, le service Framaspace a bénéficié de nombreuses améliorations via :

- plusieurs mises-à-jour majeures de Nextcloud, le logiciel derrière Framaspace ;

- le développement et l’ajout de 2 applications : Visites guidées et Transfert de propriété ;

- l’ajout de 3 autres applications : Formulaires, Tableaux et Paheko.

Framaspace, c’est aujourd’hui une suite logicielle qui intègre 13 outils :

📁 un espace de stockage / partage de documents (drive)

🗒️ une suite bureautique pour l’édition collaborative des fichiers

📷 une application pour créer des albums de photos ou des vidéos

💬 la possibilité d’échanger par conversation écrite ou en visioconférence avec les autres utilisateur⋅ices

👥 un carnet de contacts où en plus d’y enregistrer vos contacts personnels, vous pouvez créer des groupes pour les organiser et des équipes pour partager des données spécifiques

🗓️ une application pour créer des agendas, y ajouter vos événements et les partager

🗂️ un outil de gestion de projet de style kanban destiné à la planification personnelle et à l’organisation de projets en équipe

📣 un module d’annonces qui permet de publier des informations à destination de tous les utilisateur⋅ices de votre Framaspace

🔄 une application permettant aux associations qui ont rejoint Framaspace de coopérer entre elles autour de projets communautaires, en construisant des connaissances partagées via l’édition collaborative de contenus

📊 un outil pour créer des formulaires simples dont les résultats sont visibles directement ou transférés dans un fichier .csv ou un tableur

🧩 un outil de gestion de la vie associative (gestion des membres, gestion des activités et gestion comptable)

📝 une application pour gérer des listes de tâches et de les partager avec d’autres utilisateur⋅ices

🚀 un outil no code qui permet de créer des mini-applications (réservé à un public ayant une bonne maîtrise des outils numériques)

Et on ne compte pas s’arrêter là ! Même si nous proposons désormais une offre relativement complète. Avec l’installation de la version 30 de Nextcloud début 2025, de nouvelles fonctionnalités intéressantes vont être ajoutées. Pour la suite, nous envisageons de mettre en place une infrastructure plus performante pour augmenter les capacités de l’outil de visioconférence intégré à Framaspace pour que cette fonctionnalité soit accessible à davantage de participant⋅es.

De plus, nous évaluerons l’intégration de nouvelles applications, comme celle mettant à disposition un tableau blanc interactif et partagé, ou celle proposant des dossiers de groupes (qui reste pour l’instant un peu trop buguée à notre goût). Nous estimerons la pertinence d’intégrer la valorisation du bénévolat. Et nous verrons si nous avons les moyens humains et financiers d’ajouter la possibilité de créer et gérer votre site web associatif, directement depuis votre Framaspace.

Soutenir Framaspace (et Framasoft)

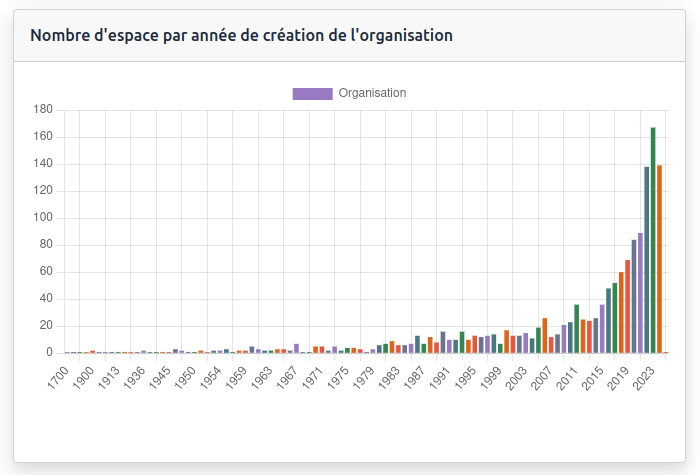

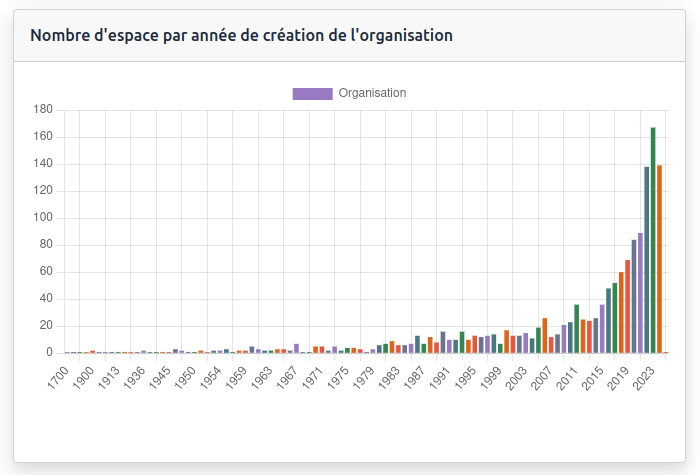

… adopté par des organisations œuvrant à la transformation sociale et environnementale

Grâce aux informations renseignées lors de chaque inscription, il nous est possible d’avoir une petite idée de qui sont les bénéficiaires de Framaspace. On constate ainsi que ce sont des structures plutôt récentes : 42 % d’entre elles ont moins de 5 ans alors que 26 % ont entre 5 et 15 ans et 32 % plus de 15 ans. Elles sont même 10 % à avoir été créées en 2024.

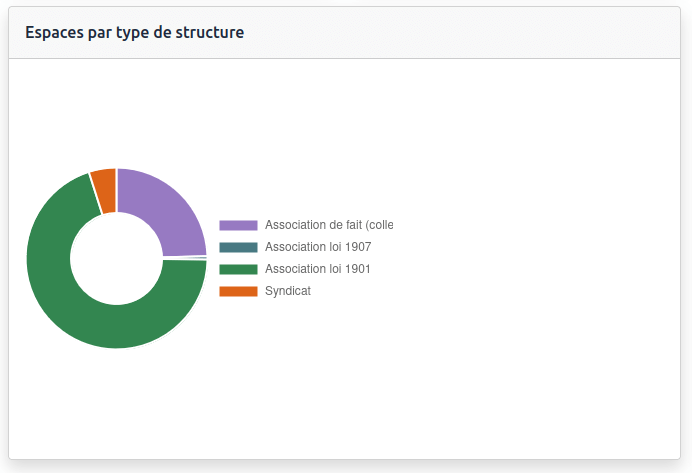

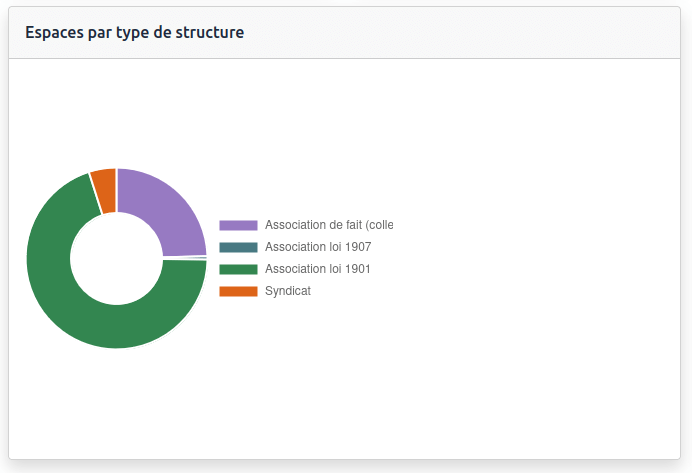

La majeure partie d’entre elles (70 %) sont constituées en associations, mais 25 % sont des collectifs informels et 5 % des syndicats.

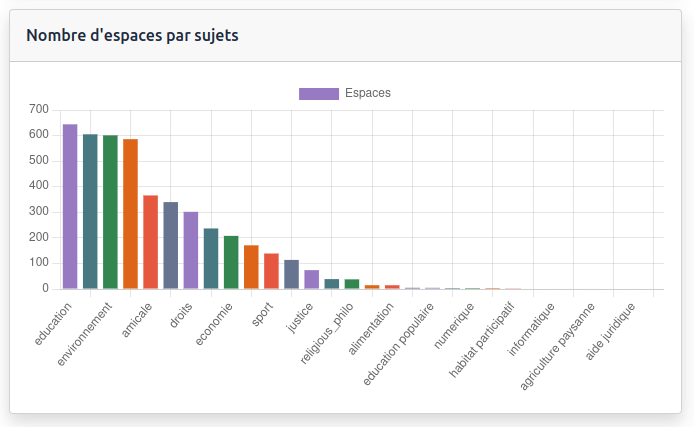

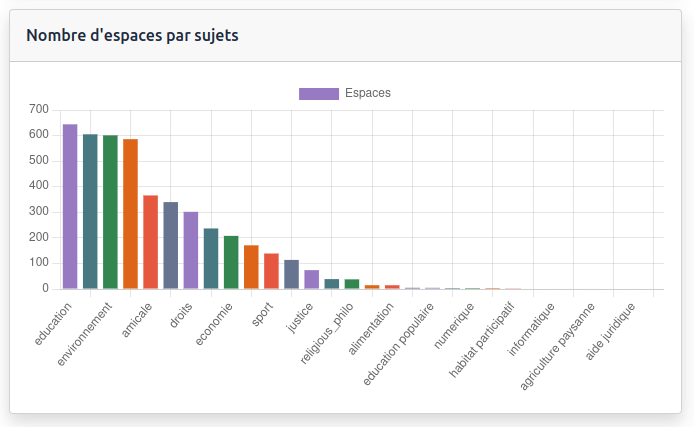

Quant à leurs domaines d’intervention, elles sont 43 % à indiquer qu’elles œuvrent dans l’éducation, 41 % dans le social et 40 % dans l’environnement.

Nous le constations déjà en 2022 et 2023 et cela se confirme en 2024 : nous avons réussi à cibler le public que nous souhaitions toucher : des associations (déclarées ou de fait) plutôt petites, avec de petits budgets dont les domaines d’intervention sont l’éducation, l’environnement, le social ou le culturel. Ce qui n’est pas étonnant quand on connaît le public de Framasoft !

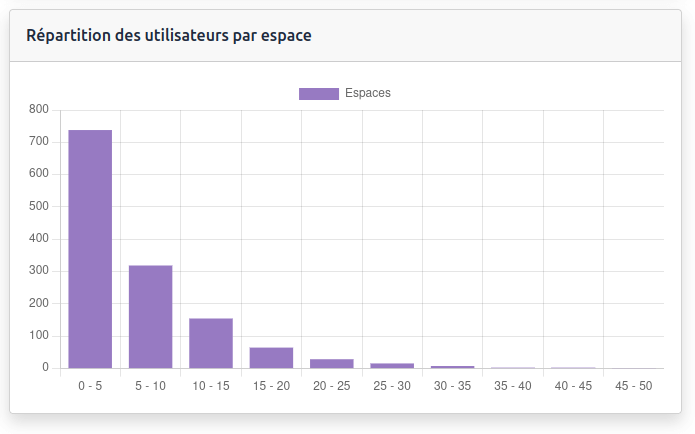

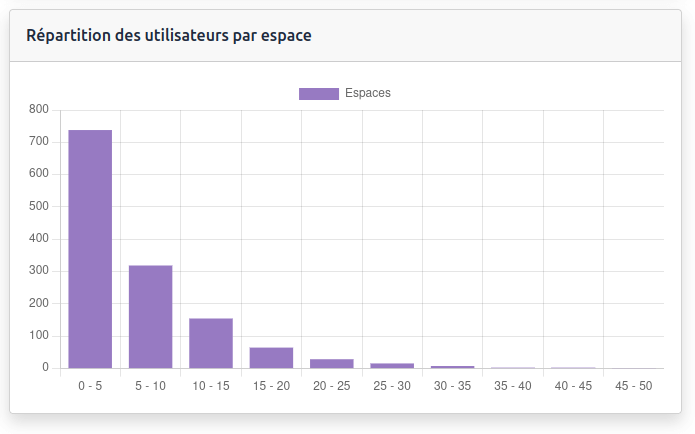

Du côté des usages, 46 % d’entre elles ont créé entre 1 et 4 comptes sur leur Framaspace, 20 % entre 5 et 9 comptes, 10 % entre 10 et 14 comptes et seulement 24 % ont créé 15 comptes et plus. Rien d’étonnant à cela puisque Framaspace est réservé aux petites organisations.

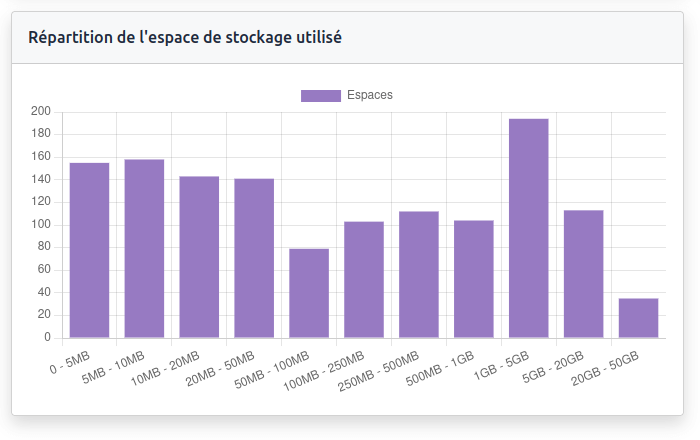

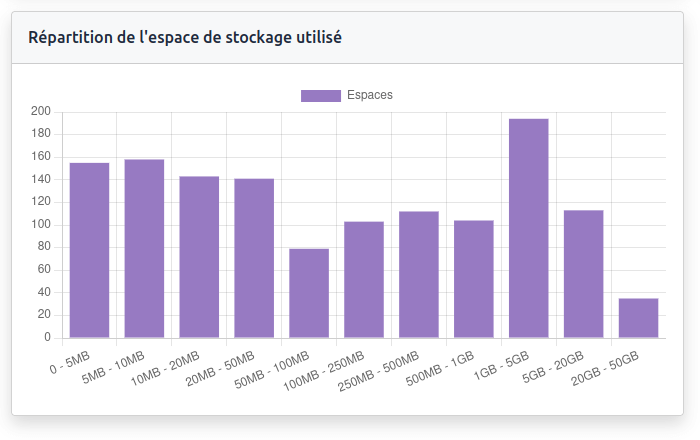

Elles sont finalement assez peu nombreuses à être contraintes par la capacité de stockage maximum que nous avons fixée : 90 % stockent sur leur Framaspace moins de 5 Go de données et seulement 2 % d’entre elles ont dépassé les 20 Go de données alors qu’elles sont 8 % à utiliser entre 5 et 20 Go.

Pour construire les fondations d’une communauté francophone d’utilisateur⋅ices de Nextcloud et favoriser l’entraide entre les utilisateur⋅ices de Framaspace, nous avons mis en place un forum. A ce jour, 388 comptes y ont été créés, ce qui est encore trop peu à notre goût au regard du nombre de structures utilisant Framaspace. En revanche, les échanges vont bon train puisque 1642 messages ont été postés au sein de 497 sujets différents.

En 2025, nous souhaitons mettre davantage d’énergie pour inciter les structures qui ne l’ont pas encore rejoint à le faire et pour animer et modérér les échanges qui s’y tiendront. Cela ne pourra évidemment se faire que si vous nous en donnez les moyens.

Soutenir les 1600 bénéficiaires de Framaspace (et Framasoft)

Et la suite ? promouvoir et faciliter l’adoption !

Le projet Framaspace n’en est qu’à ses débuts et, en 2025, nous espérons que davantage d’associations et collectifs pourront en bénéficier. Car si accueillir 1627 organisations est déjà un exploit technique, nous aimerions davantage permettre à ces structures de s’émanciper des outils des géants du web. Pour cela, nous souhaitons consacrer davantage de temps à la promotion de ce service.

Un autre objectif pour l’année à venir est de développer l’accompagnement aux usages de Framaspace. Mieux accompagner les utilisateur⋅ices, notamment celles et ceux qui découvrent Nextcloud, nous semble essentiel au regard de la complexité de l’outil. Nous allons nous lancer dans la réalisation du tutoriel interactif dont vous serez l’héroïne ou le héros et comptons produire plusieurs tutoriels sur des fonctionnalités avancées de NextCloud, en particulier sur les apps « Formulaires », « Tableaux » et « Paheko ».

Enfin, nous souhaitons inciter à la « collaboration politique » entre les espaces. Que cela soit en mettant en valeur les possibilités de « fédération » (c’est-à-dire la possibilité de lier et de partager des informations entre plusieurs espaces Framaspace ou Nextcloud), ou en proposant une « veille militante » partagée afin de faciliter les mobilisations (ce qui nous semble particulièrement essentiel en ce moment).

À la louche, on estime que le service Framaspace nous a coûté 30 000 € en 2024 : la moitié de cette somme a servi à louer des serveurs, l’autre à rémunérer les équipes techniques. Mais si en 2025, comme nous le souhaitons, nous consacrons davantage de temps à promouvoir Framaspace, développer l’accompagnement à sa prise en main et inciter à la collaboration entre utilisateur⋅ices, ces coûts vont forcément augmenter.

Nous pensons sincèrement qu’un service réalisé par une association pour des associations a du sens. Si vous le pensez aussi, que vous bénéficiez ou non d’un Framaspace, nous avons donc besoin de votre soutien, dès maintenant, afin de nous « aider à aider » ces structures non seulement à quitter les GAFAM et à mettre leurs outils en cohérence avec leurs valeurs, mais aussi et surtout à mieux agir, à mieux coopérer, à mieux créer du lien. À mieux faire société, ensemble.

Soutenir l’avenir de Framaspace (et Framasoft)

ECHO Network, comprendre les besoins de l’éducation populaire hors de nos frontières

Ethical, Commons, Humans, Open-Source Network (Réseau autour de l’Éthique, les Communs, les Humaines et l’Open-source) est un projet et un réseau de 7 structures associatives d’éducation populaire provenant de 5 pays européens (Céméa Federzione Italia, Céméa Belgique, Willi Eichler Academy, Solidar Foundation, Centar Za Mirovne Studije et Framasoft) mené par l’association d’éducation populaire des Céméa France.

Si ces organisations ont en commun d’accompagner les citoyen⋅nes dans leur autonomie et leur émancipation, elles s’interrogeaient sur comment accompagner leurs publics à s’émanciper des services des géants du web. Le projet s’est donc donné comme objectif de promouvoir la citoyenneté numérique en outillant les organisations de jeunesse et plus largement les associations, à analyser et comprendre les effets du numérique sur nos vies, nos organisations et nos relations, en tenant compte des droits des personnes ; et en proposant des alternatives numériques éthiques, respectueuses de l’environnement et des droits humains.

5 temps forts en 2023

En 2023, les partenaires du projet se sont rencontrés, ont échangé des pratiques et expérimentés des méthodes d’animation lors de 5 temps forts. Un séminaire d’ouverture s’est tenu en janvier 2023 à Paris et a été suivi de 4 visites d’études dans chacun des pays pour échanger sur les usages numériques spécifiques à leurs pays, leur culture, leur langue. Si ces rencontres ont permis une meilleure compréhension du contexte de chacun·e, elles ont surtout favorisé l’acquisition de connaissances et de compétences.

Le séminaire d’ouverture co-organisé par les Ceméa France et Framasoft a rassemblé à Paris une trentaine de participant·es représentant les partenaires du projet ECHO Network et plus de vingt personnes des réseaux de l’éducation nouvelle, de la médiation numérique, des communs et du libre. Pendant 3 jours, les participant⋅es ont pu faire connaissance et échanger sur les notions d’Éthique, de Communs, d’Humanisation et d’Ouverture dans le numérique.

lire le CR complet sur le Framablog

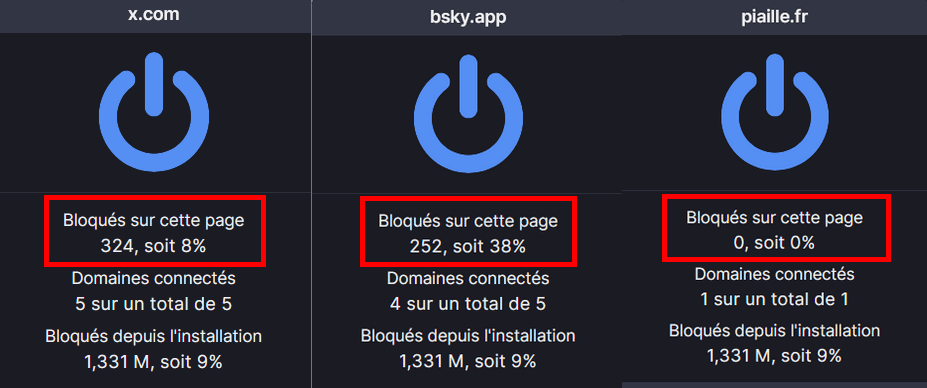

La première visite d’étude s’est tenue à Berlin du 27 au 31 mars 2023. Organisée par la Willi Eichler Akademy sur la thématique « jeunes, réseaux sociaux et éducation politique », elle a permis aux participant⋅es de questionner leurs usages des réseaux sociaux (comment partager nos messages en restant cohérent⋅es avec ce que l’on défend) et de mieux comprendre comment les jeunes générations les appréhendaient.

lire le CR complet sur le Framablog

Du 12 au 17 juin 2023, c’est sous le soleil de Bruxelles que s’est tenue la deuxième visite d’étude sur la thématique « pratiques d’éducation active pour sensibiliser aux outils éthiques ». Les participant⋅es ont pu expérimenter de nombreux formats d’animation pour partager leurs connaissances en matière de numérique éthique, mais aussi rencontrer les différentes organisations locales ou se former à la captation vidéo ou à la diffusion radio.

lire le CR complet sur le Framablog

La troisième visite d’étude s’est déroulée à Rome du 27 au 29 septembre 2023. Organisée par la fédération italienne des CEMEA autour de la thématique « Entre présentiel et distanciel, quelle utilisation du numérique ? », elle s’est articulée autour de rencontres avec plusieurs associations italiennes, dont les formateur·ices ont témoigné de leur utilisation des outils numériques en formation, d’ateliers de réflexion et de production sur les enjeux du numérique dans les formations et les contenus pédagogiques et la rencontre avec une chercheuse de l’Université de Rome Tre autour des enjeux de l’Intelligence Artificielle.

lire le CR complet sur le Framablog

Le consortium du projet ECHO Network s’est retrouvé pour la dernière visite d’étude du projet, à Zagreb du 5 au 7 décembre 2023 au Center for Peace Studies, organisation croate de défense des droits humains. Les participant·es ont pu rencontrer différentes organisations croates utilisant le numérique dans leurs activités, échanger sur la question des Droits Humains et de l’IA, sur le rôle d’Internet dans les mouvements anti-guerre en Croatie dans les années 90 et de la cyber-surveillance.

lire le CR complet sur le Framablog

2024 : production et valorisation

Après ces 4 visites d’études, le projet ECHO Network était consacré en 2024 à la production de ressources qui pourraient servir à d’autres associations en Europe. Lors d’un échange en mars, nous nous sommes mis d’accord sur la forme que prendrait nos réalisations et comment se répartir le travail. Framasoft a pris en charge la réalisation d’un site web pour présenter l’ensemble de ces productions.

Vous pouvez ainsi trouver sur le site https://echo-network.eu :

- une cartographie des structures œuvrant pour un numérique éthique à travers la formation, la construction d’outils et/ou la proposition de services

- un référentiel de ressources et outils disponibles dans le réseau des partenaires en lien avec la promotion de la citoyenneté numérique

- des démarches d’animation à destination des éducateur·ices et des jeunes pour analyser et comprendre

- un guide de survie numérique pour les représentant⋅es d’associations qui souhaitent engager une transition numérique en lien avec leurs valeurs associatives

- un plaidoyer pour une transition numérique éthique et durable

Les partenaires du projet ECHO Network se sont retrouvés une dernière fois à Bruxelles du 4 au 6 novembre 2024 pour finaliser le bilan du projet et le présenter lors d’un événement organisé par Solidar au Comité économique et social européen, un organe consultatif de l’Union Européenne. Cet événement a permis de réunir les acteurs de l’éducation et de la formation et les décideurs politiques européens lors d’une table ronde politique sur le thème de la transition numérique éthique et durable.

Présentation du projet au Comité économique et social européen

Tout au long de ce projet, nous avons pu découvrir les différences de fonctionnement, d’actions et de culture de nos structures respectives. Les activités de Framasoft sont évidemment assez différentes des méthodes d’animation des Ceméa ou des actions de plaidoyer de Solidar. De plus, nous n’avons pas pour habitude de faire des rencontres dans toute l’Europe (qui restent assez chronophages en particulier lorsqu’on évite le transport aérien), notre fonctionnement plus dynamique préfère les échanges asynchrones et à distance. Pour autant, ces rencontres nous ont permis de découvrir nos points communs et nos discours partagés, et nous nous réjouissons d’avoir apporté notre regard aux enjeux du numérique qui ont pu être discutés.

Nous espérons que les contenus présents sur ce site aideront les membres de la société civile au niveau européen à la recherche de ressources autour du numérique éthique, et nous nous efforcerons d’y référer et de diffuser ses contenus sous licence libre, en particulier au sein de notre réseau non-francophone.

Soutenir la participation de Framasoft à ECHO Network

Vous reprendrez bien un peu de numérique émancipateur pour Noël ?

Au regard de ce long bilan, et même si nous n’avons pas mené tous ces projets dans leur intégralité, nous estimons avoir atteint l’objectif que nous nous étions fixé, à savoir fournir des outils numériques aux associations et collectifs qui œuvrent pour le bien commun et le bien des Communs. Et on est sacrément fier⋅es de ce que nous avons accompli ces deux dernières années, dans un contexte mouvementé.

Pour autant, nous n’allons pas nous arrêter en si bon chemin ! Il reste encore beaucoup à faire pour que toutes les structures qui veulent changer le monde mettent en cohérence leurs outils numériques et leurs valeurs. D’ailleurs, on compte sur vous pour leur faire découvrir tout ce que nous avons mis en place ces deux dernières années. Et pour vous aider, on vous a concocté une petite vidéo qui présente en 13 min chrono l’offre de Framasoft à destination des associations.

En cette veille de Noël, et même si nous ne sommes pas hyper fans des fêtes religieuses et consuméristes, on se dit que vous nous feriez un chouette cadeau en participant à rendre virale cette vidéo ! Alors, n’hésitez pas à la partager auprès de votre famille, votre cercle amical, vos collègues et bien évidemment auprès de vos communautés.

Soutenir les actions qui dégooglisent les associations (et Framasoft)

Le défi : 20 000 fois 20 € de dons pour les 20 ans de Framasoft !

Framasoft est financée par vos dons ! Chaque tranche de 20 euros de dons sera un nouveau ballon pour célébrer 20 d’aventures et nous aider à continuer et décoller une 21e année.

Framasoft, c’est un modèle solidaire :

- 8000 donatrices en 2023 ;

- plus de 2 millions de bénéficiaires chaque mois ;

- votre don (défiscalisable à 66 %) peut bénéficier à 249 autres personnes.

À ce jour, nous avons collecté 201 425 € sur notre objectif de campagne. Il nous reste 7 jours pour convaincre les copaines et récolter de quoi faire décoller Framasoft.

Alors : défi relevé ?

🎈 Je soutiens la 21e année de Framasoft 🎈