C’EST PAS DE L’IA

Quand on entend parler d’intelligence artificielle, c’est l’histoire d’un mythe moderne qui nous est racontée. Celui d’une IA miraculeuse qui doit sauver le monde, ou d’une l’IA douée de volonté qui voudrait le détruire. Pourtant derrière cette « IA » fantasmée se trouve une réalité matérielle avec de vraies conséquences. Cette thématique sera centrale dans notre travail en 2025, voilà pourquoi nous commençons par déconstruire ces fantasmes : non, ce n’est pas de l’IA, c’est l’exploitation de la nature, l’exploitation des humains, et c’est l’ordonnancement de nos vies à des fins autoritaires ciblant toujours les personnes les plus vulnérables.

Pour faire vivre notre combat contre le numérique autoritaire, capitaliste et écocide, et poursuivre notre travail de proposition positive pour un numérique libre, émancipateur et fédérateur, nous avons besoin de votre soutien !

C’est pas de l’IA, c’est de l’exploitation dernier cri

L’IA est le prolongement direct des logiques d’exploitation capitalistes. Si cette technologie a pu émerger, c’est du fait de l’accaparement de nombreuses ressources par le secteur de la tech : d’abord nos données personnelles, puis d’immenses capitaux financiers et enfin les ressources naturelles, extraites en reposant sur le colonialisme ainsi que sur le travail humain nécessaires à l’entraînement des modèles d’IA. Une fois déployée dans le monde professionnel et le secteur public, l’IA aggrave la précarisation et la déqualification des personnes au nom d’une course effrénée à la productivité.

C’est pas de l’IA, c’est une immense infrastructure écocide

L’essor de l’IA repose sur l’extraction de minerais rares afin de fabriquer les puces électroniques indispensables à ses calculs. Elle conduit aussi à la multiplication des data centers par les multinationales de la tech, des équipements gigantesques et coûteux en énergie qu’il faut en permanence refroidir. Partout sur la planète, des communautés humaines se voient ainsi spoliées de leur eau, tandis qu’on rallume des centrales à charbons pour produire l’électricité nécessaire à leur fonctionnement. Derrière les discours de greenwashing des entreprises, les infrastructures matérielles de l’IA génèrent une augmentation effrayante de leurs émissions de gaz à effet de serre.

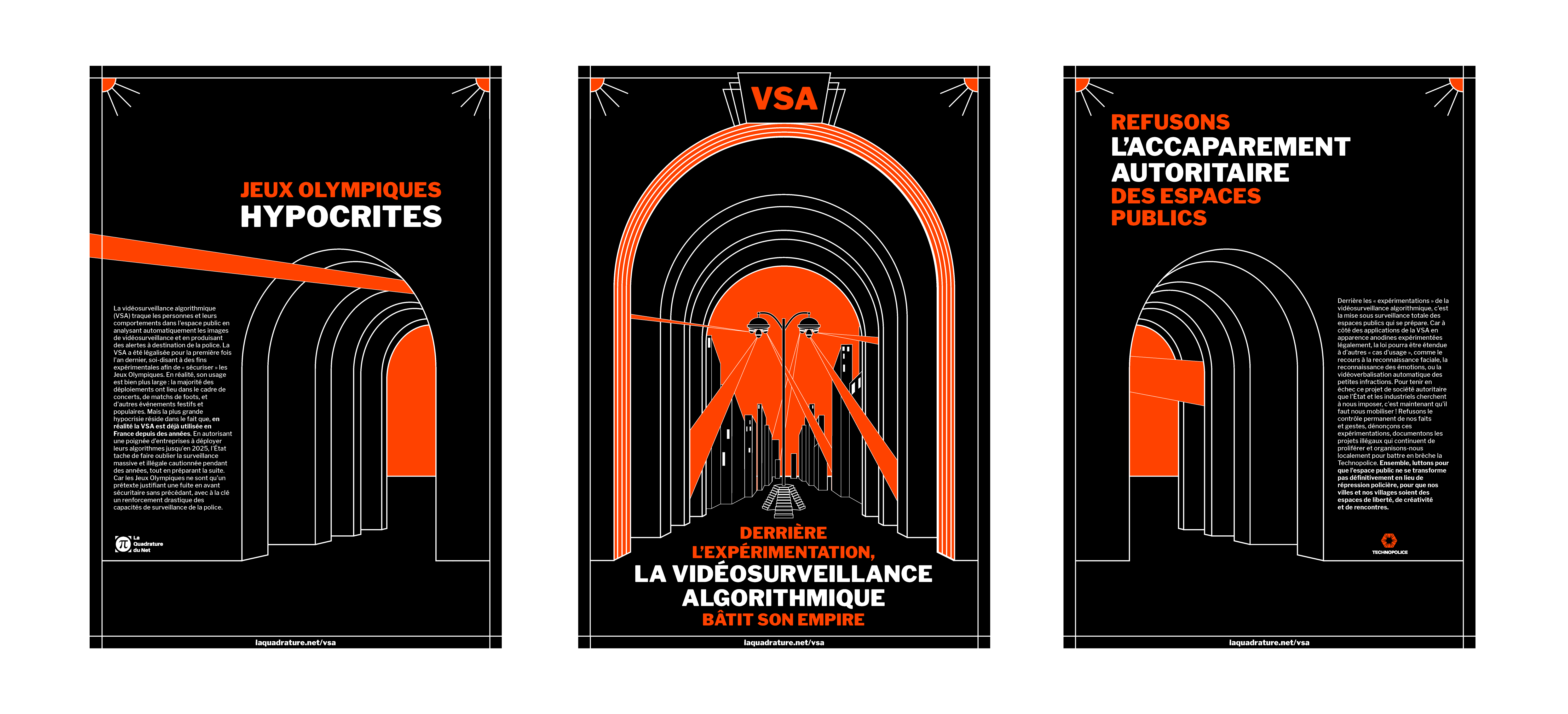

C’est pas de l’IA, c’est l’automatisation de l’État policier

Que ce soit au travers de la police prédictive ou de la vidéosurveillance algorithmique, l’IA amplifie la brutalité policière et renforce les discriminations structurelles. Derrière un vernis prétendument scientifique, ces technologies arment la répression des classes populaires et des militant·es politiques. Elles rendent possible une surveillance systématique de l’espace public urbain et, ce faisant, participent à l’avènement d’un monde où le moindre écart à la norme peut être détecté puis puni par l’État.

C’est pas de l’IA, c’est la chasse aux pauvres informatisée

Sous couvert de « rationalisation », l’IA envahit les administrations sociales à travers le développement d’algorithmes auto-apprenants visant à détecter de potentiels fraudeurs. Allocations Familiales, Assurance Maladie, Assurance Vieillesse, Mutualité Sociale Agricole : ces systèmes sont aujourd’hui déployés dans les principales administrations de l’« État providence ». Associant un « score de suspicion » à chacune d’entre nous pour sélectionner les personnes à contrôler, nos recherches montrent qu’ils ciblent délibérément les personnes les plus précaires .

C’est pas de l’IA, c’est la mise aux enchères de notre temps de cerveau disponible

L’accaparement de nos données personnelles permet de nourrir les IA de profilage publicitaire, qui associent en temps réel des publicités à nos « profils » vendus aux plus offrants. Cette marchandisation de notre attention a aussi pour effet de façonner les réseaux sociaux centralisés, régulés par des IA de recommandation de contenus qui les transforment en lieux de radicalisation binaire des camps politiques. Enfin, pour développer des produits comme ChatGPT, les entreprises du secteur doivent amasser d’immenses corpus de textes, de sons et d’images, s’appropriant pour ce faire le bien commun qu’est le Web.

Pourquoi nous faire un don cette année ?

Pour boucler le budget de l’année qui vient, nous souhaitons récolter 260 000 € de dons, en comptant les dons mensuels déjà existants, et tous les nouveaux dons mensuels ou ponctuels.

À quoi servent concrètement vos dons ?

L’association a une fantastique équipe de membres bénévoles, mais elle a aussi besoin d’une équipe salariée.

Les dons recueillis servent principalement à payer les salaires des permanentes de l’association (75 % des dépenses). Les autres frais à couvrir sont le loyer et l’entretien du local, les déplacements en France et à l’étranger (en train uniquement), les frais liés aux campagnes et aux évènements ainsi que les divers frais matériels propres à toute activité militante (affiches, stickers, papier, imprimante, t-shirts, etc.).

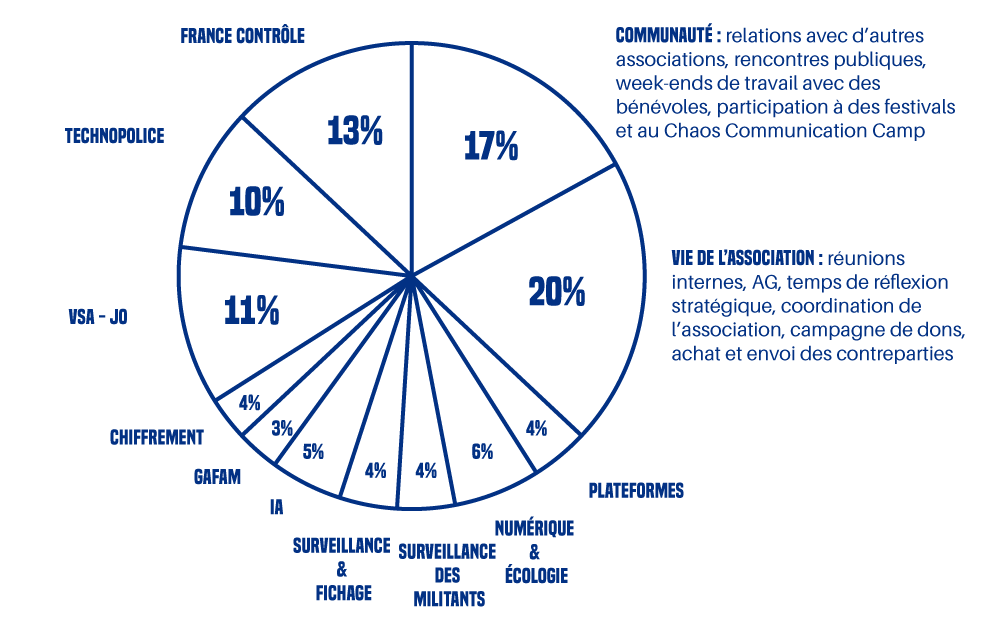

Pour vous donner une idée, quand on ventile nos dépenses de 2024 (salaires inclus) sur nos campagnes, en fonction du temps passé par chacun·e sur les sujets de nos luttes, ça ressemble à ça :

Quelles sont nos sources de financement ?

L’association ne touche aucun argent public, mais reçoit des soutiens, à hauteur de 40 % de son budget, de la part de diverses fondations philanthropiques : la Fondation pour le progrès de l’Homme, la fondation Un monde par tous, Open Society Foundations, la Limelight Foundation et le Digital Freedom Fund.

Le reste de notre budget provient de vos dons. Alors si vous le pouvez, aidez-nous !

Attention, comme nous l’expliquons dans la FAQ de notre site, les dons qui sont faits à La Quadrature ne sont pas déductibles des impôts, les services fiscaux nous ayant refusé cette possibilité à deux reprises.

Comment donner ?

Vous pouvez faire un don par CB, par chèque, ou par virement bancaire.

Et si vous pouvez faire un don mensuel — même un tout petit ! — n’hésitez pas, ce sont nos préférés : en nous assurant des rentrées d’argent tout au long de l’année, ils nous permettent de travailler avec plus de confiance dans la pérennité de nos actions.

En plus, le cumul de vos dons vous donne droit à des contreparties (sac, t-shirt, sweat). Attention, l’envoi n’est pas automatique, il faut vous connecter et faire la demande sur votre page personnelle de donateur/donatrice. Et si les contreparties tardent un peu à arriver, ce qui n’est pas rare, c’est parce qu’on est débordé·es, ou qu’on attend le réassort dans certaines tailles, et aussi parce qu’on fait tout ça nous-mêmes avec nos petites mains. Mais elles finissent toujours par arriver !

Merci encore pour votre générosité, et merci beaucoup pour votre patience Faire un don

Version pour consultation numérique ( double-pages )

Version pour consultation numérique ( double-pages ) Version pour impression ( page par page )

Version pour impression ( page par page )