Briefcam au Ministère de l’Intérieur : le rapport d’inspection tente de noyer le poisson

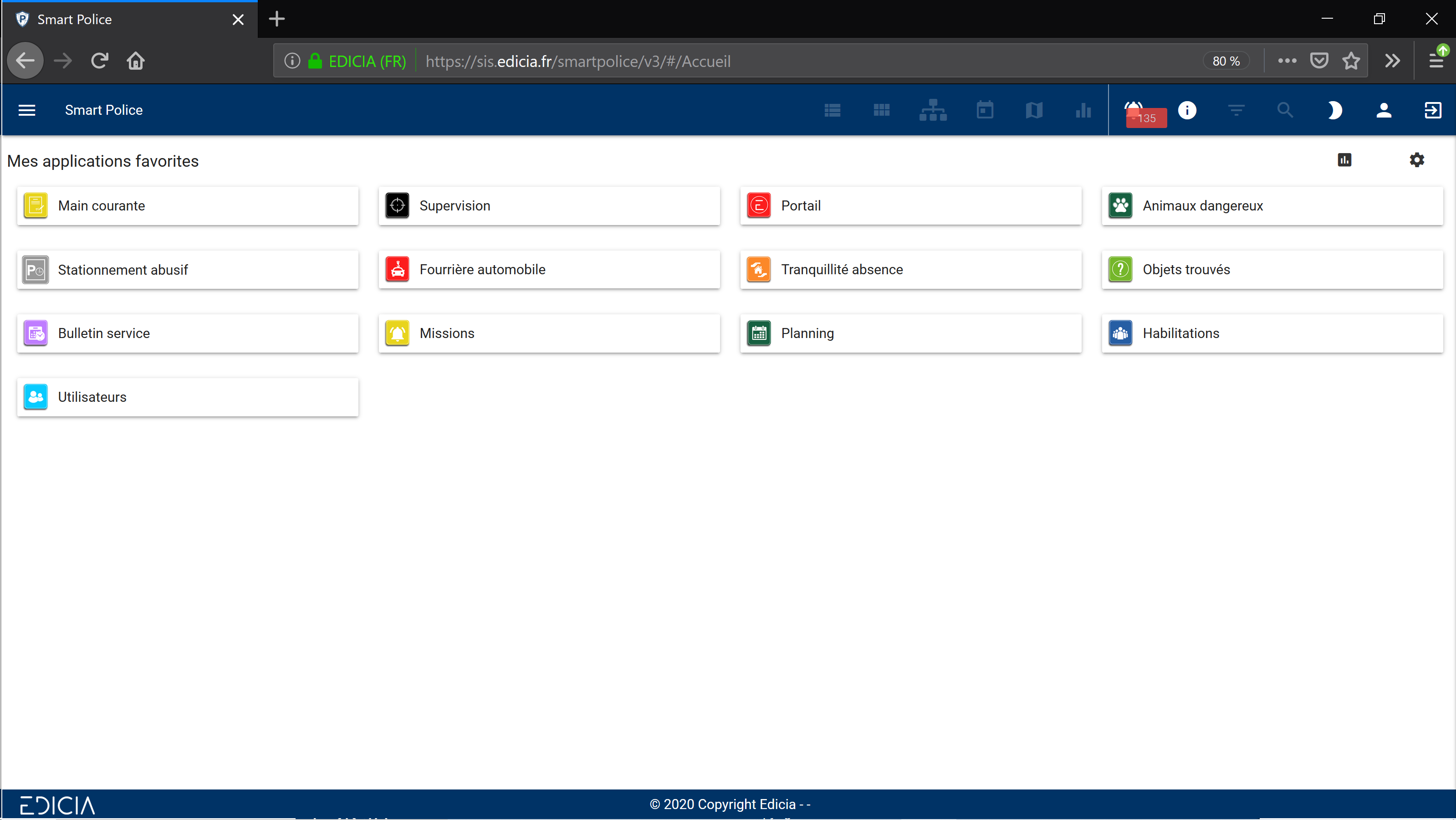

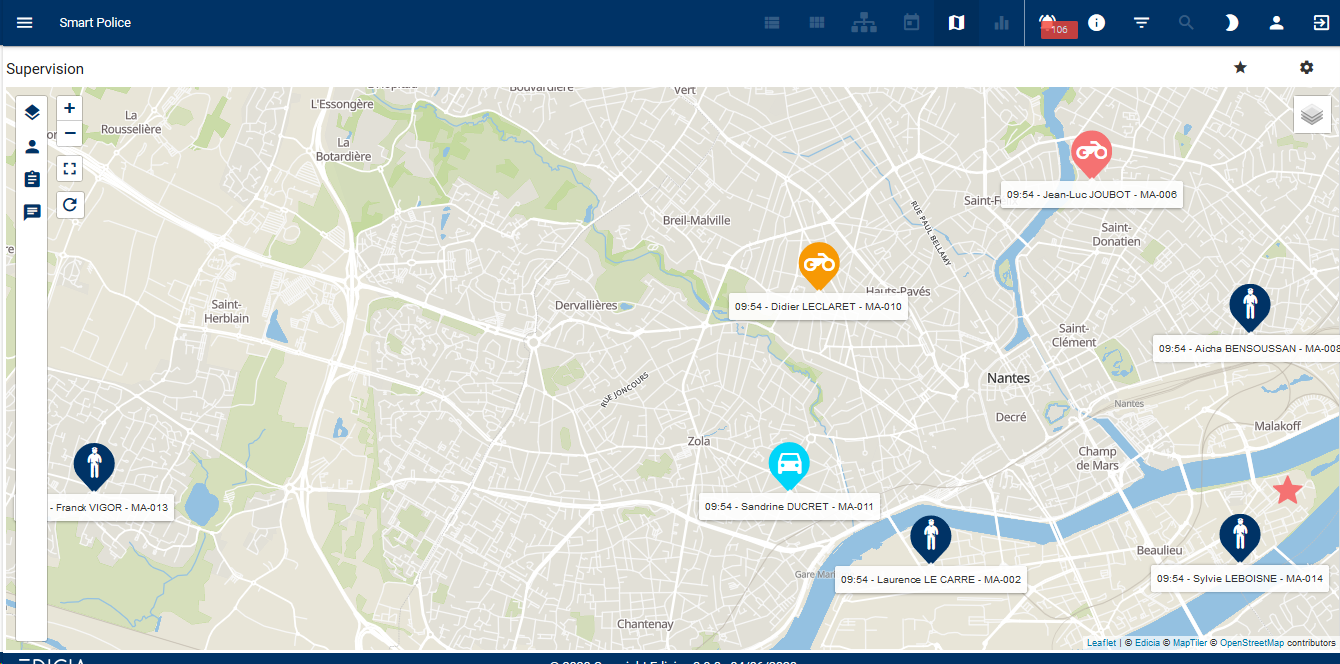

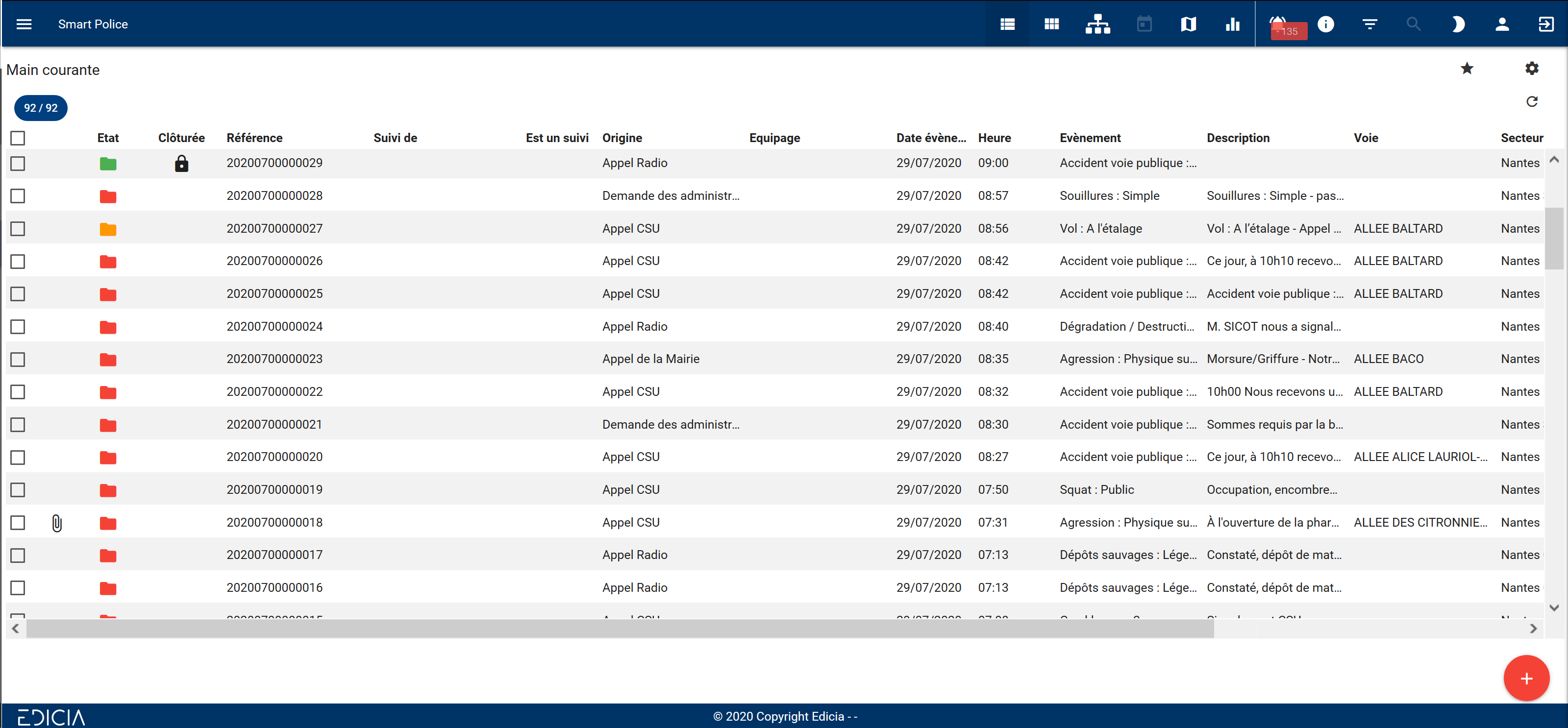

L’an dernier, le média d’investigation Disclose révélait que depuis des années, en se sachant dans l’illégalité la plus totale, la police nationale avait recouru au logiciel de l’entreprise israélienne Briefcam, qui permet d’automatiser l’analyse des images de vidéosurveillance. Cette solution comporte une option « reconnaissance faciale » qui, d’après Disclose, serait « activement utilisée ». Après avoir tenté d’étouffer l’affaire, le ministère de l’Intérieur a enfin publié le rapport d’inspection commandé à l’époque par Gérald Darmanin pour tenter d’éteindre la polémique. Ce rapport, rédigé par des membres de l’Inspection générale de l’administration, de l’Inspection générale de la police nationale et de l’Inspection de la Gendarmerie nationale, permet d’étayer les révélations de Disclose. Fondé sur la seule bonne foi des forces de l’ordre, il s’apparente toutefois à une tentative choquante de couvrir des faits passibles de sanctions pénales.

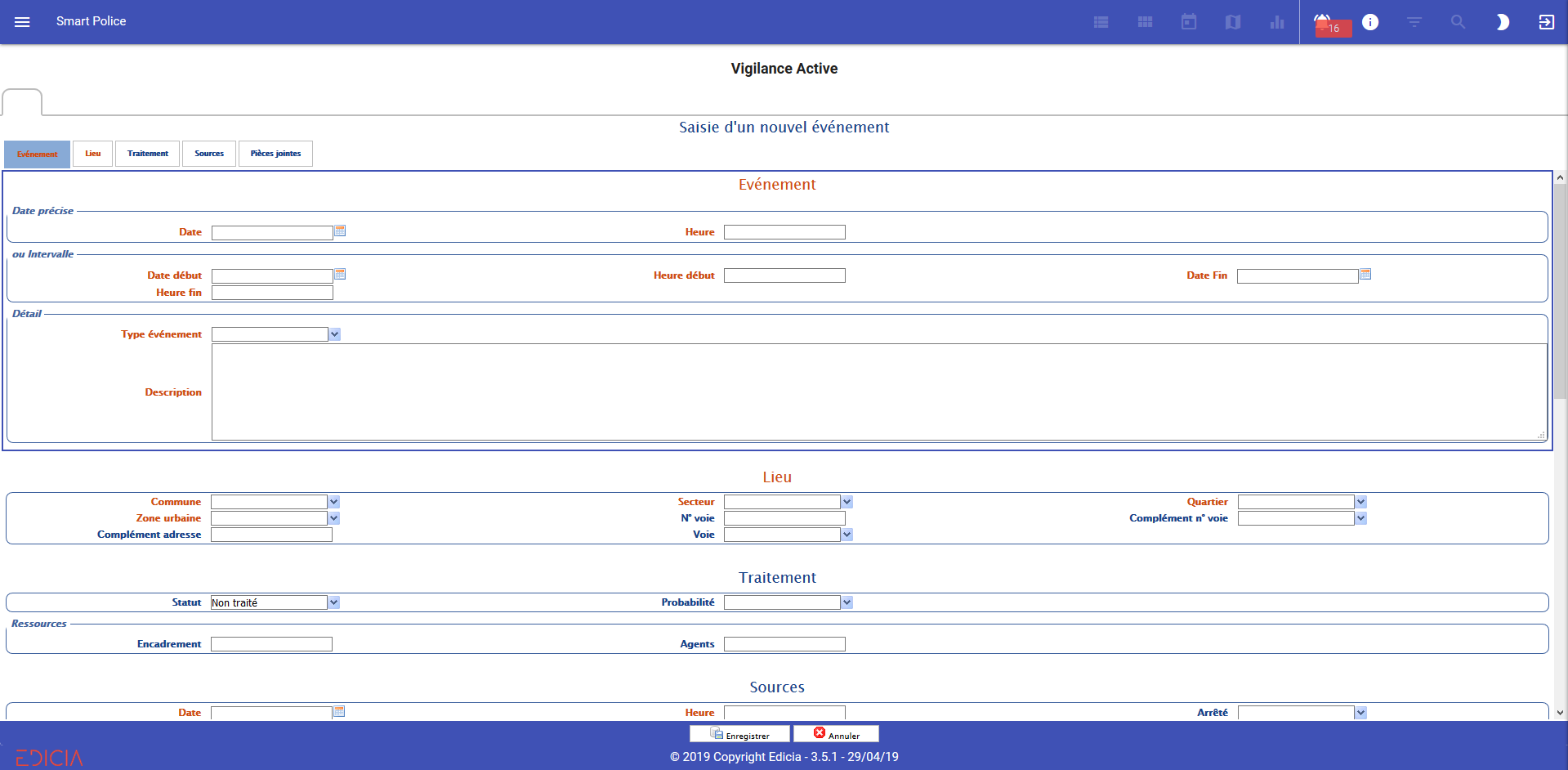

Tout au long du rapport, les auteur·rices utilisent diverses techniques de minimisation et d’euphémisation – quand il ne s’agit pas tout bonnement de mauvaise foi – pour justifier l’utilisation illégale du logiciel Briefcam depuis 2015 par la police et 2017 par la gendarmerie. Pour rappel, ce logiciel permet d’analyser et filtrer les attributs physiques des personnes filmées afin de les retrouver sur les enregistrements vidéo. En plus de la reconnaissance faciale, il propose la reconnaissance de vêtements, de genre, de taille, d’apparence ou encore la « similitude de visage » que les services tentent grossièrement de distinguer de la reconnaissance faciale alors qu’au fond, il s’agit peu ou prou de la même chose, à savoir identifier des personnes. Plutôt que de reconnaître l’usage hors-la-loi de l’ensemble de ces cas d’usages depuis quasiment dix ans, les services d’inspection multiplient les pirouettes juridiques pour mieux légitimer ces pratiques.

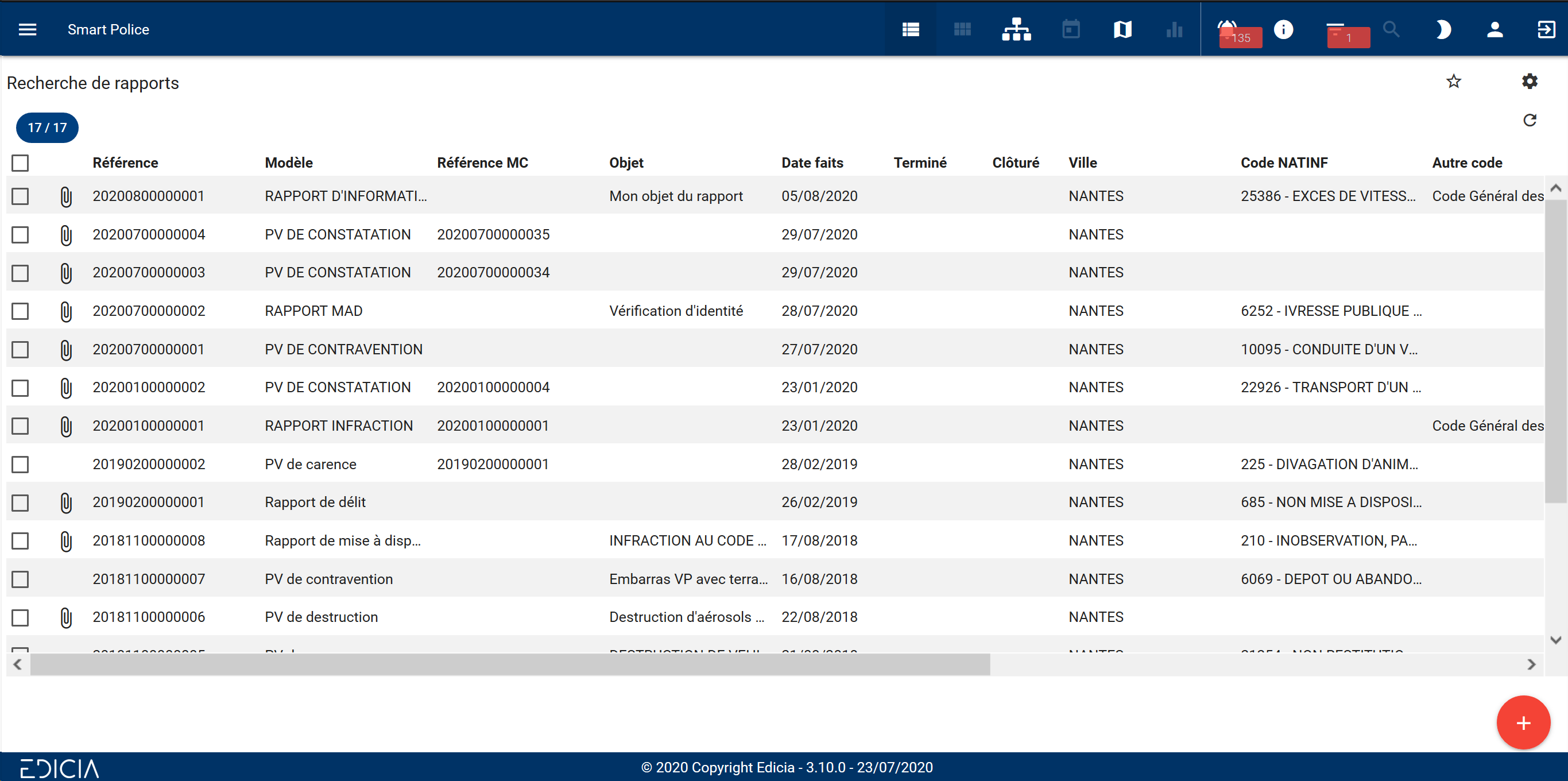

Ainsi, les auteur·rices du rapport reprennent une analyse bancale déjà esquissée par Gérald Darmanin l’an dernier pour couvrir un usage intrinsèquement illégal de VSA dans le cadre d’enquêtes pénales, lorsque ces dispositifs sont utilisés par les enquêteurs pour analyser automatiquement des flux de vidéosurveillance archivés. Reprenant l’interprétation secrètement proposée en interne par les services du ministère de l’Intérieur pour couvrir ces activités au plan juridique, les auteur·rices estiment que ces utilisations a posteriori (par opposition au temps réel) de logiciels de VSA constitueraient des logiciels de « rapprochement judiciaire » au sens de l’article 230-20 du code de procédure pénale. Pourtant, cet article du code de procédure pénale n’autorise que le « rapprochement de modes opératoires » (par exemple des logiciels d’analyse de documents pour faire ressortir des numéros de téléphones liés entre eux). Cela n’a rien à voir avec la VSA a posteriori, laquelle consiste à rechercher des personnes sur une image en fonction de leurs attributs physiques via des techniques d’intelligence artificielle. Pour être licites, ces dispositifs devraient au minimum faire l’objet d’une base légale spécifique. C’est la base en matière de droits fondamentaux. Et cette base n’a clairement pas été respectée.

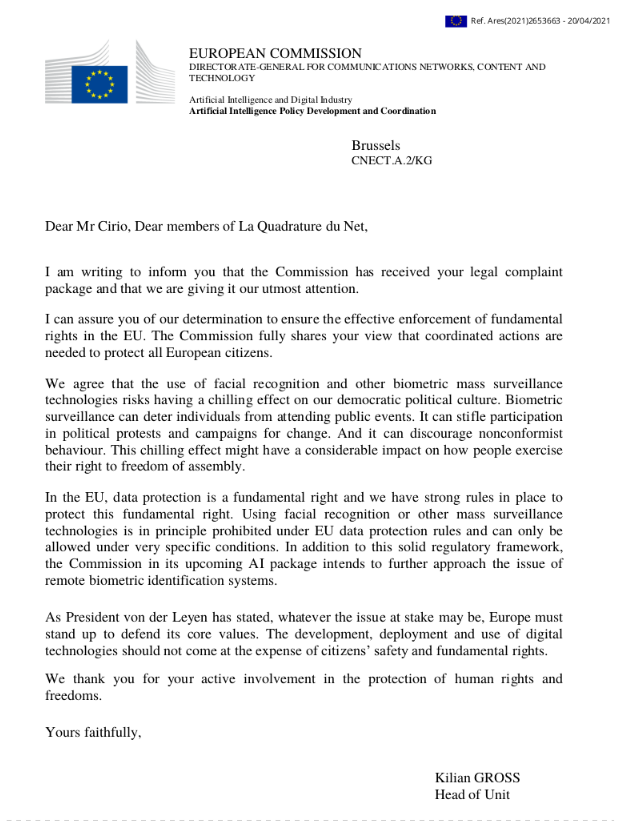

L’argumentation des rapporteurs paraît d’autant plus choquante que le logiciel VSA de Briefcam analyse des données personnelles biométriques et est donc soumis à des restrictions fortes du RGPD et de la directive police-justice. Les lacunes du cadre légal actuel pour des usages de VSA dans le cadre d’enquêtes judiciaires et la nécessité d’une base légale spécifique est d’ailleurs confortée par différents projets de légalisation de cette technologie qui ont pu être proposés : tel est le cas de la récente proposition de loi relative à la sûreté dans les transports, ou plus anciennement un projet de décret de 2017 « autorisant des traitements de données personnelles permettant l’analyse des enregistrements vidéo dans le cadre d’enquêtes judiciaires », mentionné dans le rapport. De même, l’autorisation par un décret de 2012 du recours à la comparaison faciale dans le fichier TAJ (« Traitement des antécédants judiciaires ») illustre la nécessité parfois bien comprise au ministère de l’Intérieur de prévoir un encadrement juridique spécifique pour différentes technologies de surveillance mobilisée dans le cadre d’enquête pénale1.

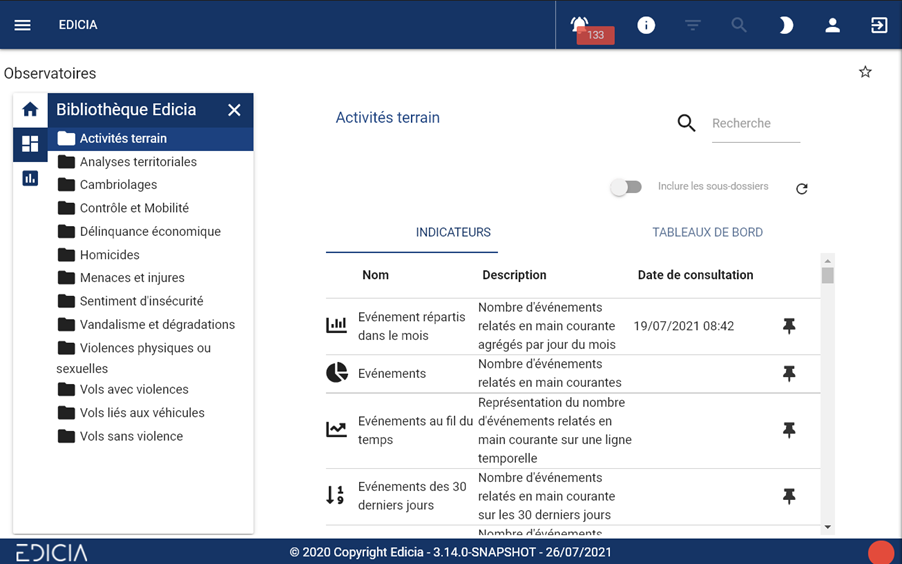

Non content·es de couvrir des abus pourtant passibles de sanctions pénales, les auteur·ices du rapport envisagent aussi l’avenir. Iels proposent ainsi de relâcher encore davantage la bride de la police pour lui permettre de tester de nouvelles technologies de surveillance policière. Assouplir toujours plus les modalités de contrôle, déjà parfaitement défaillantes, dans la logique des « bacs à sable réglementaires », à savoir des dispositifs expérimentaux dérogeant aux règles en matière de protection des droits fondamentaux, le tout au nom de ce qu’iels désignent comme l’« innovation permanente ». Les auteur·rices s’inscrivent en cela dans la filiation du règlement IA qui encourage ces mêmes bacs à sable réglementaires, et du rapport Aghion-Bouverot (commission de l’intelligence artificielle) rendu au printemps dernier2. Il faut bien mesurer que ces propositions inacceptables, si elles venaient à être effectivement mises en œuvre, sonneraient le glas des promesses de la loi « informatique et libertés » en matière de protection des droits fondamentaux et des libertés publiques (à ce sujet, on est toujours en attente de l’issue de l’autosaisine de la CNIL dans ce qu’il faut bien appeler « l’affaire Briefcam », un an après son déclenchement…).

En bref, ce rapport s’inscrit dans une logique de couverture de faits passibles de peines de prison et qui constituent aussi un détournement de fonds publics. Surtout, il contribue à banaliser la vidéosurveillance algorithmique, suivant en cela la politique du gouvernement Barnier. En effet, après avoir annoncé le mois dernier la pérennisation de « l’expérimentation » de la VSA suite aux Jeux Olympiques, le gouvernement entend également, via le projet de loi de finances 2025, d’installer des radars routiers dopés à la VSA pour détecter trois nouvelles infractions concernant « l’inter-distance (entre les véhicules), le non-respect du port de la ceinture et le téléphone tenu en main (au volant) ». Sans oublier la proposition de loi sur la sécurité dans les transports qui fait son retour à l’Assemblée d’ici la fin du mois de novembre. Tout est bon pour légitimer cette technologie dangereuse et l’imposer à la population.

Pour nous aider à tenir ces manœuvres en échec, RDV sur notre page de campagne !

- La police et la gendarmerie utilisent de façon très fréquente la reconnaissance faciale en application de ce cadre lié au fichier TAJ : en 2021, c’était 498 871 fois par la police nationale et environ 117 000 fois par la gendarmerie nationale, d’après un rapport parlementaire.

︎

︎ - Le rapport Aghion-Bouverot appelait à l’assouplissement de certaines procédures d’autorisation pour utiliser des données personnelles, notamment dans la santé ou par la police. On y lit notamment :

« Le RGPD a renversé complètement la logique du droit qui prévalait en France depuis la loi « informatique et liberté » de 1978 Alors que la possibilité de traiter des données à caractère personnel reposait sur des procédures d’autorisation ou de déclaration préalables auprès de l’administration, le RGPD a posé les principes de liberté et de responsabilité : les acteurs sont libres de créer et de mettre en œuvre des traitements de données à caractère personnel, sous réserve de veiller eux-mêmes à la conformité de ces traitements aux principes et règles prévus par le règlement européen Ils doivent en particulier analyser les risques spécifiques que peuvent créer les traitements les plus sensibles et prendre les mesures appropriées pour y remédier En contrepartie de cette liberté, instituée dans le but précis de favoriser l’innovation, les exigences de protection des données personnelles ont été renforcées, de même que les pouvoirs de contrôle et de sanction a posteriori des autorités en charge de la protection des données En France, il s’agit de la Commission nationale de l’informatique et des libertés (Cnil).

En France, cette évolution n’a pas été conduite jusqu’à son terme Il demeure des procédures d’autorisation préalables non prévues par le droit européen. C’est en particulier le cas pour l’accès aux données de santé pour la recherche Une procédure simplifiée de déclaration de conformité à des méthodologies de référence existe mais elle est loin d’être généralisée En pratique, la procédure simplifiée reste l’exception par rapport à la procédure d’autorisation préalable car le moindre écart par rapport à ces méthodologies implique d’en passer par une autorisation préalable qui peut impliquer jusqu’à trois niveaux d’autorisation préalable On trouve des lourdeurs analogues dans les domaines de l’ordre public, de la sécurité et de la justice ». ︎

︎

︎

︎